佛系程序员

首页

栏目

标签

归档

关于

友链

佛系程序员

首页

栏目

标签

归档

友链

关于

心理咨询AI助手项目运行说明-windows安装ollama及心理模型

学习笔记

网站开发

发布日期: 2025-04-16 19:57:02

喜欢量: 8 个

阅读次数:

1172

心理咨询

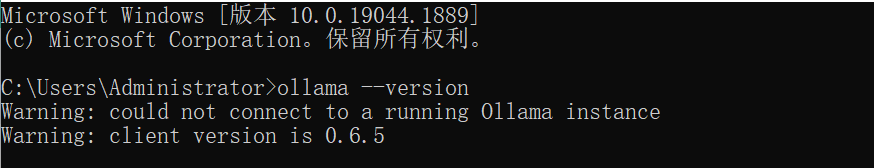

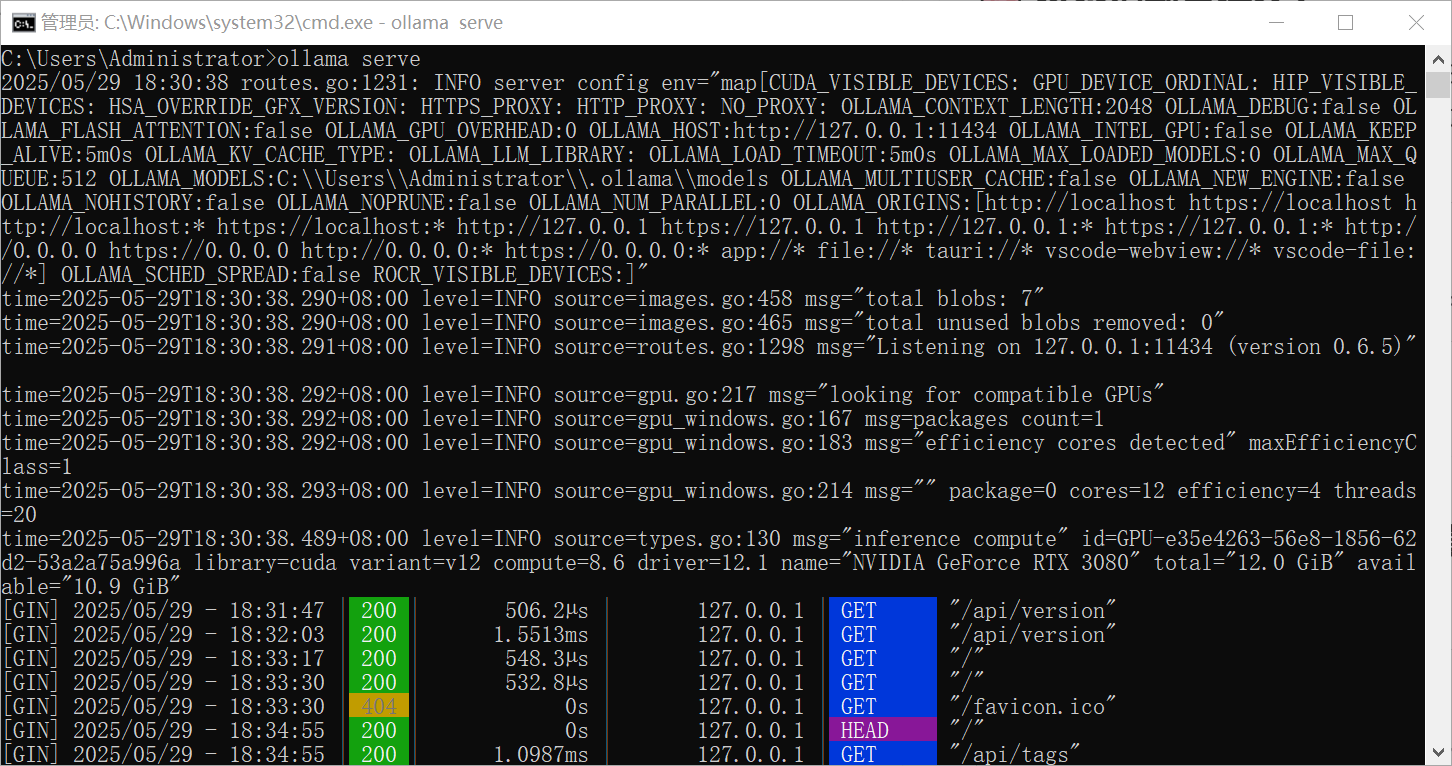

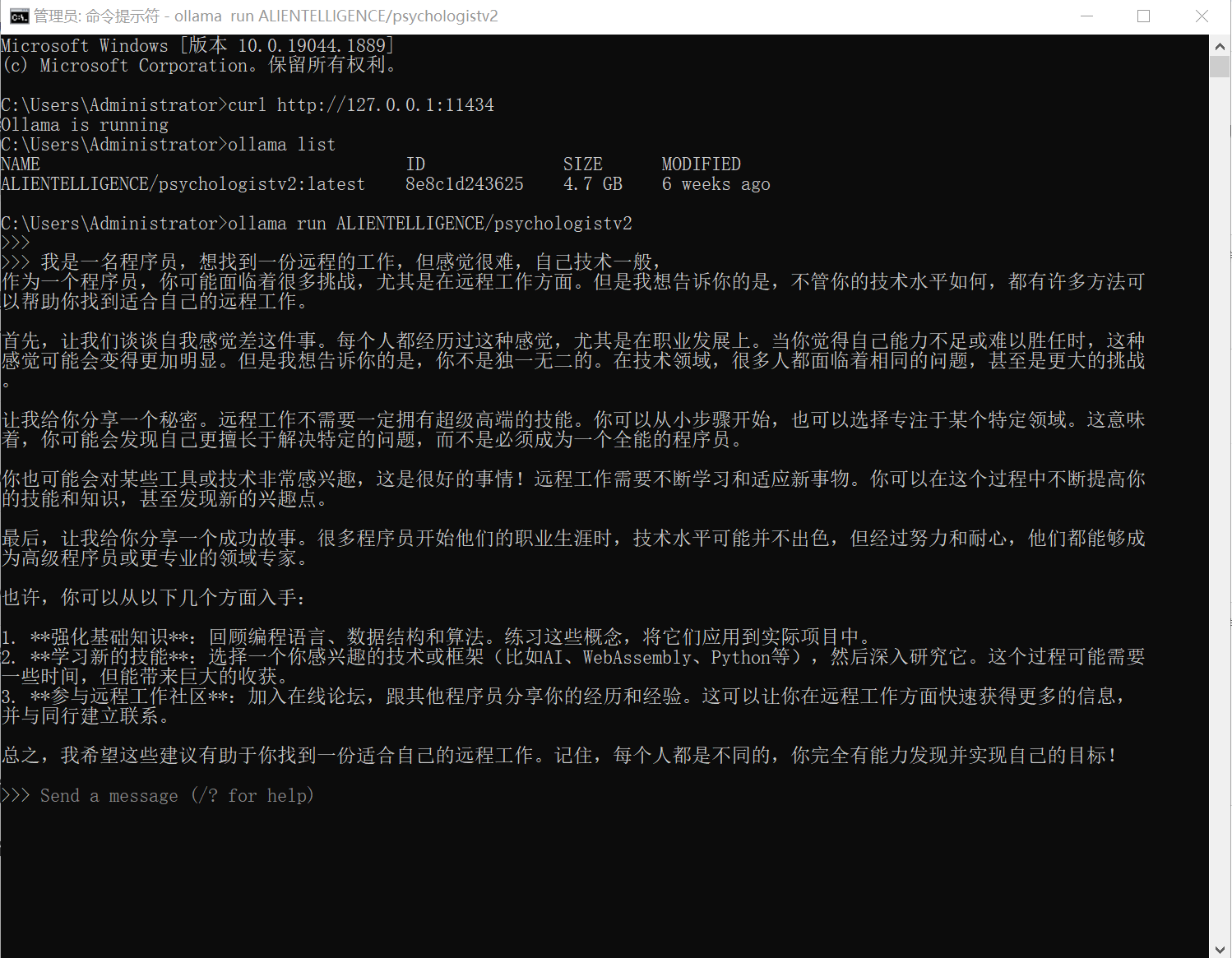

Windows 安装 Ollama ## 下载Ollama,安装 通过 Ollama 官方网站 下载适用于 Windows 的安装包,然后按照提示安装。 或者:使用 PowerShell 的来下载 Ollama: 1. 使用 PowerShell 下载: ```bash Invoke-WebRequest -Uri "https://ollama.ai/download/OllamaSetup.exe" -OutFile "OllamaSetup.exe" ``` 2. 运行安装程序(需要管理员权限): ```bash Start-Process "OllamaSetup.exe" -Verb RunAs ``` 如果下载速度较慢,我们可以使用国内镜像: ```bash Invoke-WebRequest -Uri "https://mirror.ghproxy.com/https://github.com/ollama/ollama/releases/latest/download/ollama-windows-amd64.exe" -OutFile "OllamaSetup.exe" ``` ## 验证安装 安装完成后: 1. 重启电脑 2. 打开新的 PowerShell 窗口 3. 验证安装: ```bash ollama --version ``` 需要我提供更多镜像源或其他安装方式吗? ## 错误处理 在安装模型时,默认保存在C盘,进行到一半时,我修改了环境变量。因为C盘空间不够了。我想把Models保存在E盘。 在 用户变量 或 系统变量 中,点击 "新建" 来添加一个新的环境变量。 设置如下: 变量名:OLLAMA_MODELS_PATH 变量值:E:\OllamaModels Ollama 支持断点续传功能。当你中断下载后重新执行 pull 命令时,它会从上次下载的位置继续。 如果你想要在新位置重新开始下载,需要先清理之前的下载缓存: 1. 停止 Ollama 服务: ```bash ollama serve stop ``` 2. 删除已下载的模型文件: ```bash ollama rm ALIENTELLIGENCE/psychologistv2 ``` 3. 然后重新下载: ```bash ollama pull ALIENTELLIGENCE/psychologistv2 ``` 如果还是继续使用旧的下载缓存,可以手动清理缓存目录: ```bash rd /s /q "%USERPROFILE%\.ollama\models" ``` 需要我帮你清理缓存重新下载吗? 安装完成后,你可以在 PowerShell 或命令提示符下运行类似的命令来启动模型 ```bash # Windows ollama run llama2 ``` 这样就安装了 llama2 模型了。 ## 启动模型 多日之后,我忘了这台电脑的安装情况了, ```bash ollama --version ```  启动 ```bash ollama serve ```  查看运行起来了,查看已经 安装的模型,运行模型 ```bash curl http://127.0.0.1:11434 ollama list ollama run ALIENTELLIGENCE/psychologistv2 ```  -- 下面可忽略 -- # 心理咨询AI助手项目运行说明 ## 1. 项目概述 这是一个基于多个大语言模型的心理咨询AI助手系统,主要功能包括: - 心理咨询对话 - 危机干预检测 - 情绪分析 - 系统状态监控 ## 2. 系统架构 ### 2.1 核心组件 - FastAPI后端服务 (<mcfile name="app.py" path="/Users/mac/data/pythonProjects/mind/app.py"></mcfile>) - 模型管理器 (<mcfile name="model_manager.py" path="/Users/mac/data/pythonProjects/mind/model_manager.py"></mcfile>) - 系统监控器 (<mcfile name="monitor.py" path="/Users/mac/data/pythonProjects/mind/monitor.py"></mcfile>) ### 2.2 使用的模型 - 主咨询模型:ALIENTELLIGENCE/psychologistv2 - 危机检测模型:ALIENTELLIGENCE/mindpal - CBT辅助模型:ryanrwatkins/llama3-psychologist - 情绪分析模型:qwen:7b ## 3. 环境要求 ### 3.1 硬件要求 - CPU: 多核处理器 - 内存: 至少32GB - GPU: 支持CUDA的NVIDIA显卡,显存至少6GB(NVIDIA GeForce RTX 3080 是支持 CUDA 的) - 存储: 50GB以上可用空间 ### 3.2 软件要求 - Python 3.8+ - Ollama - FastAPI - uvicorn - psutil - GPUtil ## 4. 安装步骤 ### 4.1 安装基础环境 ```bash # 安装Python依赖 pip install fastapi uvicorn requests psutil gputil ``` ### 4.2 安装Ollama MacOS 安装 ```bash # MacOS curl -fsSL https://ollama.com/install.sh | sh ``` ### 4.3 下载必要模型 ```bash # 使用model_manager.py下载模型 python model_manager.py ``` ## 5. 运行说明 ### 5.1 启动服务 1. 启动系统监控 ```bash python monitor.py ``` 2. 启动FastAPI服务 ```bash uvicorn app:app --host 0.0.0.0 --port 8000 ``` ### 5.2 API接口 #### 主要接口 - 健康检查: `GET /` - 咨询对话: `POST /chat` ```json { "text": "用户输入的文本" } ``` #### 响应格式 ```json { "response": "AI回复内容", "risk_level": 0-10, "emotion": "情绪分析结果" } ``` ## 6. 监控和维护 ### 6.1 系统监控 系统会自动记录以下指标到 <mcfile name="system_monitor.log" path="/Users/mac/data/pythonProjects/mind/system_monitor.log"></mcfile>: - CPU使用率 - 内存使用情况 - GPU使用率和显存 - 温度警告(如果GPU温度超过80°C) ### 6.2 错误处理 - 所有API错误都会返回标准HTTP错误码 - 系统日志记录在app.log中 - 监控日志记录在system_monitor.log中 ## 7. 注意事项 1. 模型加载 - 确保有足够的系统资源运行多个模型 - 模型首次加载可能需要较长时间 2. 安全考虑 - 高风险对话会触发紧急响应机制 - 系统会记录关键操作日志 3. 性能优化 - 使用了并行处理来提高响应速度 - 支持流式响应减少等待时间 4. 维护建议 - 定期检查系统监控日志 - 保持模型更新到最新版本 - 定期清理日志文件 ## 8. 故障排除 1. 如果服务无法启动: - 检查Ollama服务是否运行 - 确认所需模型是否已下载 - 验证端口8000是否被占用 2. 如果响应很慢: - 检查系统监控日志中的资源使用情况 - 考虑减少并发请求数 - 确认GPU是否正常工作 3. 如果出现内存错误: - 检查system_monitor.log中的内存使用情况 - 考虑增加系统内存 - 可能需要限制并发请求数 ---

文章作者:

yyii

文章链接:

https://www.amtb.info/show/MTcw

版权声明:

本博客所有文章除特別声明外,转载请注明来源

佛系程序员

!

分享:

搜索